올해 건강검진에서는 처음으로 위대장 내시경을 받았다. 처음 겪는 내시경 절차에 긴장이 되었다. 무엇보다 전날 금식이 걱정되었지만, 의외로 나는 식욕이 그리 강하지 않아 금식이 큰 부담으로 다가오지 않았다. 그렇게 건강검진 당일이 다가오고, 알약을 먹으며 속을 비워냈다. 처음에는 무난했다. 속이 점차 비워지는 느낌은 청소하는 듯한 기분을 주었고, 그리 나쁘지 않았다.

늘 먹던 음식이였다. 그래서 조금은 귀찮았다. 매번 고파지는 배는 다른 것에 집중하기 힘들게 만들어서 흐름을 깨어 놓기 일쑤였다. 그래서 식사에 대해서 그다지 좋은 감정을 갖고 있지는 않았다. 그나마 최근들어서 식사시간은 잠시 쉬면서 일과 멀어지게 한뒤, 다시 새로운 기분으로 일에 집중할 수 있는 용도로 사용하기 좋은 시간 이구나를 깨달은 뒤로 일부로라로 식사시간에 집중하려던 참이 이였지만, 그마저도 주말이나 휴가때는 잘 지켜지지 않았다.

이렇듯, 나는 그다지 음식을 크게 좋아하지 않거나 중요하게 생각하지 않았는데, 이렇게 금식을 강제로 하다 보니 갑자기 음식에 대한 아쉬운 감정이 들었다. 누군가는 사랑하는 사람과 함께 음식을 나누는 것이 가장 큰 행복이라고 말하고, 또 다른 이들은 스트레스를 받을 때 자극적인 음식을 먹으며 풀어야 한다고 한다. 그런 말들이 이 아쉬운 감정에서 나온 것일까, 잠시 생각해 보았다.

이 상황이 신기했다. 평소에는 지루하고 귀찮게 여겨졌던 식사가, 이제는 강제로 억제당하자 아쉬움으로 변한 것이다. 내시경 검사를 마친 후, 나는 두툼하고 육중한 고기 패티와 치즈를 듬뿍 올린 햄버거가 먹고 싶어졌다. 나는 그동안 언제, 무엇을 먹고 싶다는 생각을 해본 적이 있었을까? 이 감정은 정말 놀라웠다. 무엇이 나를 이렇게까지 먹고 싶게 만든 것일까?

결핍이란 무엇일까? 사람은 왜 그렇게까지 결핍을 느끼며, 그것을 채우려고 애쓰는 것일까? 아마도 결핍은 단순한 몸의 영양을 채우려는 호르몬 작용일 것이다. 그러나 당연히 있어야 할 것들이 사라지면, 그제서야 우리는 그것을 원하게 된다.

결핍은 우리가 가지고 있는 것을 제한당했을 때 생기는 것이다. 우리는 결핍을 충족시키기 위해 살아가고, 그 결핍이 충족되면 또 다른 결핍을 채우기 위해 또 다른 욕망을 느끼게 된다. 결국, 우리의 삶은 결핍을 채우고 그것을 유지하기 위해 끊임없이 움직인다.

그렇다면, 지금 나의 결핍은 무엇일까? 지금 내가 채워야 할 결핍은 무엇일까? 결핍은 우리에게 끊임없이 생각하게 만든다. 결핍을 채우려는 노력 속에서 우리는 자주 자신을 돌아보고, 무엇이 진정으로 중요한지 깨닫게 된다. 우리가 인생에서 무엇을 추구하고, 무엇을 이루려 하는지에 대해 다시 한 번 점검하게 되는 것이다. 결핍을 경험하는 것은 우리가 더 나은 삶을 살아가기 위한 성장의 과정이기도 하다. 그것은 단순히 부족함을 느끼는 것이 아니라, 우리가 더 풍요롭고 의미 있는 삶을 살아가기 위한 자극이자 원동력이다.

결핍이 없으면 우리는 현실에 안주할 위험에 처할지도 모른다. 결핍은 우리가 무엇을 목표로 삼아야 할지, 무엇을 추구할지 알려준다. 결핍을 경험하면서 우리는 더 나은 자신을 만들어 가며, 삶의 의미를 다시 한 번 되새긴다. 그것은 우리가 삶의 흐름에 따라 변하고 성장하는 과정에서 중요한 역할을 한다. 결국, 결핍이 있기 때문에 우리는 계속해서 앞으로 나아가고, 그 속에서 진정한 삶의 의미를 발견할 수 있다.

분류 전체보기

결핍에 대하여

취미의 분류

취미는 사회생활 속에서 지친 육신을 달래주고 다음 주를 살아갈 동기를 부여한다.

사무직이 헬스나 여행이 취미인 것처럼, 택시기사에겐 드라이브가 취미가 못된 것처럼 사회생활로 충족시키지 못했던 자극을 취미로 가지는 경우가 많다. 이처럼 취미는 살아가는데 주위를 환기시켜 주는 중요한 역할을 한다.

누군가는 이렇게 이야기한다. 취미는 돈 쓰는 것, 밖으로 나가는 것, 성취감이 있는 것 이렇게 3가지의 취미를 가지는 것이

삶의 질을 높이는 방법이라고. 이 의견에도 충분히 동의한다. 하지만 본인의 사회에서의 모습을 인지하고 취미로써 해소해나가게 하기 위해서는 취미에 대해서 심층적으로 나누어서 볼 필요가 있다.

1차원적 분류

취미를 가장 크게 나누어본다면, 2가지로 나눌 수 있을 것이다. 정적인 취미와 동적인 취미. 여기서 각각의 분류에는 어떤 취미가 속할까.

정적인 취미

- 뜨개질, 책 읽기, 공예, 꽃꽂이, 등

동적인 취미

- 축구, 드라이브, 헬스, 검도 등

그림으로 그려보면 위와 같이 일차원 좌표평면상에 두 점으로 나타낼 수 있을 것이다. 이는 일반적인 사람들이 생각하는 취미의 분류이다. 대부분의 사람들이 스스로의 성향에 따라 정적인 취미와 동적인취미를 가진다. 내향적인 사람은 정적인 취미를. 외향적인 사람은 동적인 취미 활동을 하면서 새로운 기운을 얻는다. 물론 내향적인 사람이 동적인 취미를 가질 수도 있고 외향적인 사람도 정적인 취미를 가질 수 있다.

하지만 예를 들어보자.

필자는 주중을 살면서 동적인 취미가 하고 싶었다. 그래서 운동을 생각했지만 막상 주말이 되니 주중 회식의 여파와, 일독이 풀리지 않아서 운동을 하기 싫었다. 그럼에도 활동적인 무언가를 하고 싶었지만 어떤 대안이 떠오르지 않아서 결국 아무것도 하지 못했다. 계획은 틀어졌고 방향을 잃은 나는 아무것도 하지 못하고 하루를 흘려보내고 말았다.

이런 분류 체계라면 계획이 틀어졌을 때 쉽게 대안을 마련할 수 없을 것이다. 1차원적 분류체계라면 동적인 취미는 몸을 움직여야만 하는 취미이기 때문이다.

그렇다면 동적인 취미라는 것은 무엇일까. 단순히 밖에 나가서 몸을 움직이는 것을 뜻할까? 아니다. 어떤 활력을 불어넣어 주고 어떤 것을 소모했다는 뿌듯함과 개운함이 동시에 포함된 취미를 나타낸다고 할 수 있다. 그렇다면 꼭 몸을 움직여야 동적인 취미라 할 수 있을까?

2차원적 분류

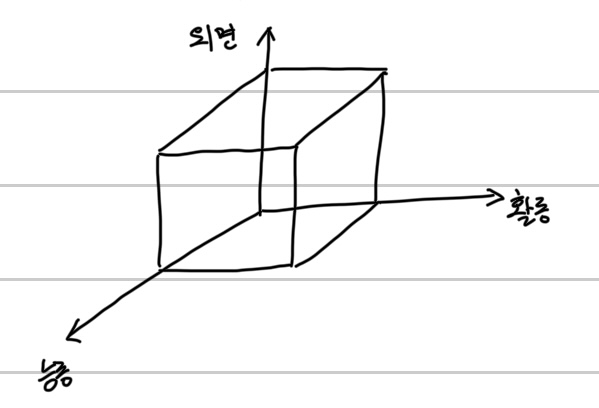

필자는 여기서 취미의 분류를 좀 더 세분화하고 싶다. 동적인취미와 정적인 취미와 더불어 몸을 소모하느냐, 정신을 소모하느냐 즉 외면을 소모하느냐, 내면을 소모하느냐로 말이다.

이렇게 세분화를 한번 더하고 나면 취미는 크게 4가지로 나뉜다. 동적이면서 정신을 소모하는 취미, 동적이면서 신체를 소모하는 취미, 정적이면서 정신을 소모하는 취미, 정적이면서 신체를 소모하는 취미. 이를 그림으로 나타내면 다음과 같이 2차원 좌표평면을 그릴 수 있을 것이다.

그렇다면 각각의 분류에는 어떤 취미가 속해질까.

동적이면서 내면을 소모하는 취미

- 글쓰기 등

동적이면서 외면을 소모하는 취미

- 축구, 등산, 드라이브 등

정적이면서 내면을 소모하는 하는 취미

- 책 읽기 등

정적이면서 외면을 소모하는 하는 취미

- 만들기 등

좀 전의 예를 다시 들어보자. 몸은 단지 어떤 동적인 활동을 통해 호르몬을 얻어 몸의 균형을 맞추고 싶었을 테지만, 그것에 대한 적절한 분류체계와 경험이 없는 나는 활동적인 걸 하고 싶다는 몸의 신호에 '활동적인 게 뭐가 있을까? -> 아 운동이 있지!' 하고 주말 운동을 하려고 계획을 짰을 것이다. 하지만 당시 상황이 운동을 하지 못하는 상황이 되자 스트레스를 풀지 못하는 상황에 놓이게 된 것이다.

하지만 위의 분류대로라면 단순히 운동 말고도 어떤 고민과 해결방안을 통한 동적이면서 내면에 집중하는 취미를 통해 뇌가 원하는 호르몬을 분비할 수 있었을 것이고 여가시간을 의미 있게 보낼 수 있었을 것이다.

3차원적 분류

또한 취미라고 하는 것은 대부분이 배우는 것과 연관되어 있다. 여가시간마다 원데이클래스로 배우거나 집에서 책을 보고 연구하 거나한 것처럼 사회생활을 하는 사람들은 무언가를 배움으로써 새로운 취미를 만 들길 원한다. 따라서 취미를 한 차원 더 세분화한다면 취미를 하는 주체가 능동적인지, 수동적인지로 나눌 수 있을 것이다.

간단히 말하면, 능동적인 취미란 어떤 것을 배움에 있어서 스스로 연구하고 독학하는 것과 같이 자발적으로 계획해서 움직이는 것을 나타내며 수동적인 취미란 배움에 있어서 누군가의 가르침을 받아 지식을 습득하는 것을 뜻한다.

기존의 활동의 강도에 따른 x축 외면과 내면을 소모하는 정도에 따른 y축에 주체의 능수동의 정도에 따른 z 축을 추가하면 아래와 같은 그림이 나올 것이다.

각각에 분류에 따라 다음과 같이 나눌 수 있다.

분류와 포함되는 취미에 대해 알아보자.

동적으로 내면을 소모하는 수동적인 취미

- 글쓰기강의수강, 원데이클래스 수강 등

동적으로 내면을 소모하는 능동적인 취미

- 에세이, 시, 소설 쓰기 등

동적으로 외면을 소모하는 수동적인 취미

- PT 1:다 수업 골프클래스 등

동적으로 외면을 소모하는 능동적인 취미

- 축구경기, 야구경기, 헬스 등

정적으로 내면을 소모하는 수동적인 취미

- 책 읽는 법 배우기, 음악듣는법 배우기 등

정적으로 내면을 소모하는 능동적인 취미

- 책 읽기, 음악 듣기, 라디오 듣기 등

정적으로 외면을 소모하는 수동적인 취미

- 브루잉원데이 클래스, 공예 원데이 클래스 등

정적으로 외면을 소모하는 능동적인 취미

- 브루잉, 공예 등

이처럼 취미를 3차원상의 그래프로 나타내여 보았다.

이렇게 분류하고 보니 취미에 대해 다양한 접근이 가능할 것 같아 보인다. 예를 들어 한 주 동안 야외에서 많이 활동한 아래 직급들은 좀 더 정적이고 능동적이고 내면을 소모하는 취미를 가지며 다시 회복할 수 있을 것이고, 실내에서 많이 활동한 윗직급 들은 동적이고 수동적이며 외면을 소모하는 취미는 가지며 회복할 수 있을 것이다. 물론 모든 예가 정답은 아니겠지만.

물론 필자가 생각한 분류기준 외에 다양한 기준이 있을 것이라는 걸 잘 안다.(좋은 의견이 있으면 댓글로 남겨주길 바란다.)

이런 분류체계를 가지고 있다면 그때그때 변하는 상황에 따라 쉽게 대처할 수 있을 뿐만 아니라 현재 본인에게 맞는 취미를 찾고 있는 사람에게도 도움이 될 것 같다.

분류체계를 정리하고 보니 아직 배워야 할 것도 많고 취미의 빈 공간을 메워야 하는 부분도 보인다. 나도 각 포인트에 대응하는 취미를 가지도록 노력해야겠다.

커피

언제부터였을까 회사에서 의미 없이 마시던 아메리카노 한잔에 관심이 가던 순간이.

처음엔 그저 피곤을 억누르기 위해서 마시기 시작했다. 누군가의 말처럼 체력포션 (마시면 일정 HP를 회복시켜 줌) 정도에 지나지 않았다.

정말 숨이 벅찰 때 마시는 아이스 아메리카노 한 모금은 나의 달아오른 두 볼과 심신을 안정시켜 주기 충분한 온도였고

그 시원함과 카페인이 온몸에 퍼지는 그 순간은 바쁜 일상을 잠시 미뤄두고 한숨 돌리기 충분한 화학작용을 일으켰다.

그리고 지인들과 함께 마시는 커피 한잔은 서로의 시간을 공유하기에 충분했고, 또 누군가와는 이 커피 한잔의 시간을 꼭 갖고 싶어서 이리저리 기회도 엿보곤 했으며, 또 누군가와는 이 시간도 아까워서 애써 바쁜 척하기도 했다.

그때부터였을까.

도대체 이 커피라는 게 우리의 삶에 어떤 의미를 가지게 된 걸까 의문이 들었던 게..

무엇보다도 이 커피타임에 소비하는 시간에 대한 의미를 찾고 싶었다.

의미 없이 주문하는 아이스 아메리카노의 의미를 찾고 싶었달까...

처음엔 어디서부터 시작해야 할지 몰라서 무작정스페셜티라 불리는 원두 몇 개를 샀다.

케냐, 콜롬비아, 에티오피아. 과테말라. 엘살바도로, 무엇인지 모르겠지만

어디서 들어본 듯한 이름 원두를 생산할 것만 같은 나라들로 이름을 추려 원두를 샀다.

그리고 드리퍼랑 주전자로 사야지.

유튜브를 보면서 칼리타? 하디오?라는 이름도 들어보고 다이소로 달려가서 눈에 보이는 드리퍼와 필터를 샀다.

참 커피하나 내려먹는데 이렇게 까지 해야 하는지 싶다가도 소소하게 사모으는 재미와 집에서 커피를 내려먹는다는 뿌듯함 같은 감정이 들어서 계속해보기로 했다.

장비를 갖추었으니 어떻게 내려야 하는지 레시피를 찾아봐야지.

테츠카츠야, 정인성, 안스타, 커핑포스트 등등 다양한 유튜버들의 이야기를 들으면서 나름의 통찰을 찾으려고 열심히 봤는데 크게 와닿지는 않았다. 단어로 모르겠고, 커피하나 내리는데 굵기, 물온도. 등등 이렇게 내리면 부정적인 맛? 저러면 깔끔한 맛? 무슨 말을 하는지도 잘 모르겠고 그냥 머릿속이 더 복잡해지는 기분이었다.

'에잇 모르겠다 일단 내려나 보자'라는 생각으로 무턱대고 원두 봉투를 뜯었다.

그리고 대망의 첫 브루잉.

굉장히 익숙한 이름 "케냐 AA" 테이스팅노트는 뭐 살구, 체리 말린 과일? 커피에서 어떻게 이런 맛이 난다고 그럴까. 정말 나긴 하는 걸까. 반신반의하며 리싱을 하고 천천히 물을 부어보았다.

처음 내리는 커피 향은 이전에는 없단 향으로 온 집을 덮었고, 내려오는 짙은 갈색의 물은 나의 마음을 더욱 들뜨게 했다.

신기했다. '내가 커피를 내리다니' 흥분되는 마음을 가라앉히고 천천히 잔에 옮겨 담고 한 모금 마셔보았다.

"윽!"

한마디 외 딴 비명과 함께 첫 브루잉을 마치게 되었다.

처음은 되게 시고, 나중엔 되게 쓰기도 했다.

커피를 마시는데 목은 왜 이리 아프며 머리도 띵하면서 아프더라

이 무슨 입안에서 부터 목 머리 등이 아주 난리가 났다.

그래서 부랴부랴 물을 더 붓고 나니 그래도 나름 마실만한 정도가 되었다.

마시면서 바디감이라는 건 어떤 느낌을 뜻하는 거지, 이런 게 산미라는 걸까?

무수히 많은 의문만을 남긴 첫 브루잉이었다.

그리고 그렇게 몇 달이 지났다. 아직도 난 커피에 대해서 잘 알지 못한다.

그럼에도 일주일에 한-두 번은 집에서 드립을 내려마시기 위해 드리퍼를 꺼내고 주전자를 데운다.

이제는 제법 익숙해진 것 같다.

비록 다양한 레시피나 원두를 마셔본 건 아니지만 일반 로스터리 카페에 가면 그날그날 맛있어 보이는 원두를 선택해서

내려달라고 한다. 그리고 내가 예상했던 그 맛이 맞는지 비교해 보기도 하고, 같이 간 사람과 의견을 나누기도 한다.

그리고 회사에서 아무 의미 없이 마셨던 그 한잔의 커피를 이제는 이 잔에 대한 여유와 더불어 원두에 대해 생각해 보기도 하고 맛에 대해서 음미해보기도 하면서 꽤나 다채로운 순간순간을 보내기도 한다.

이전까지는 미처 알아채지 못하고 지나갔다면 이제는 이런 순간이 기다려지고, 차츰 어떤 의미를 가지게 되는 것 같다.

매번 의미 없이 접했던 것들에 대해 다시 한번 되뇌고 그것에 집중해 보면서 어떤 의미를 찾아가는 것이 무채색의 바쁜 일상 살아가면서 하나의 색상 혹은 돌파구가 되지 않을까?

가족

어린 시절 가장 일시적이고 의미 없는 것은 인간관계라 생각했다.

모든 게 흘러가고 사라지는 현대사회에서 눈에 띄지 않는 관계에 의미를 두는 건

꽤나 부질없는 것처럼 보였고 그래서 나를 위한 투자에 힘쓰려고 했다.

그리고 "내가 그만한 위치에 서면 관계는 따라온다"라는 말처럼

현재의 관계에 안주하지 않으려고 했다.

그래서 초점을 맞춘 것이 "명예 " 즉 커리어였다.

그래서 대학시절 전공을 살리기 위해 힘썼고

직장에 다니면서 전공을 포기하지 않기 위해 하는 일에 대한 정체성을 끊임없이 찾으려 애썼고

책임감을 가지고 일하면 커리어에 분명 도움이 될 것이라고 생각하려 했다.

그렇게 나만의 커리어를 만들어가고 있었는데

지금 되돌아보니 남아있는 건

이력서한줄

산더미처럼 남아 있는 일

주말출근

...

물론 내가 선택해서 지나온 길이지만

오늘따라 유난히 허탈한 기분이 든다.

날씨는 이렇게 좋아졌는데, 따뜻해졌는데

이것들을 즐길 여유가.

체력이 없다는 게 슬퍼서일까,

다들 계절을 만끽하는게 배아파서일까.

무엇을 위해 이렇게 노력해 왔는지 길을 읽은 기분이다.

그렇다고 관계를 위해 이 정도의 시간을 쏟았으면 뭐가 더 나아졌을까?

꼭 그럴 것 같지는 않다.

싸우고 헤어지고 서로 안 좋은 감정만 남아 더 허탈했지도 모른다.

너무 밖으로만 시선을 돌리다 보니

나의 정성과 시간이 연기처럼 사라진적이 많다

소모적인 바깥세상에 정성을 쏟으니 그럴 수밖에 없었던 것일까?

그렇다면 이제는 어디에 초점을 맞추고 살아야 할까

지난날의 결과를 요약해 보자면

사람이 주는 성과는 이별이었다.

놀이가 주는 성과는 피폐함이었다.

일이 주는 성과는 일이다.

이제 남은 것은 사랑, 즉 사랑하는 사람,

가족에 힘을 쏟아야 하는 것일까.

지금까지 가족이라는 품 안에서 바깥세상만을 바라봤다면

이제부터는 뒤를 돌아 내 가족을 바라봐야 하지 않을까

그러면 삶의 의미를 찾을 수 있으려나

위로

각자의 힘듦은 어디서 위로 받을 수 있나

누구에게서 위로 받을 수 있을까

그저 먹먹할만큼 조용함속에서

정리되지 않은 머릿속을 헤매이는 것이

유일한 쉼이 되어버린 지금

누구의 탓도 아니게 되어비린 이 상황을 찬찬히 곱씹어본다

왜 이렇게 되어버린걸까,

미리 신경을 썼더라면.

조금더 면밀히 살펴보았더라면

이런 불상사는생기지 않았을텐데.

아무리 모르는게 약이라지만 내가 조금만 더 알았으면 어떻게든 힘이되지 않았을까.

여기저기서 솟아나는 미련과 아쉬움에 나의 지난날을 되돌아보게 한다.

그간 너무 자만하지 않았는지

나자신을 과대평가하지 않았는지

모든것을 너무 만만하게 보진 않았는지.

과연 내가 잘할 수 있을까.

나는 그럴만한 능력이 되는 사람일까 고민이 된다.

누군가의 도움없이 스스로 일어설 수 있을 남이 언제쯤 올까.

나에게 너무 과분한 일을 하고 있는 것일까,

모든게 계획대로 되지않다 느낄때가 있다

누군가는 계획대로 되는게 어찌 삶이겠냐 당연한것이다 이야기한다

누군가는 모두가 힘드니 너만 힘든게 아니라한다

또 누군가는 고생했다 이해해주고 다독여주려한다

어떤 위로가 나에게 가장 위로가 되었을까?

그리고 어떤 위로가 내일 하루도 버틸수있게 해주는걸까?

퇴근후의 공허함

요즘 들어서 문득 느끼는 것이지만 주말은 언제나 온다.

사무실 안이 아무리 시끄러워도 바깥세상은 너무나 조용하다.

그리고 그 속은 나름대로의 소란함이 있어 다른 소란함을 신경쓰지 못한다.

사회생활을 한다는 것은 아마도 하루에 주어진 일을 정리하고

집에 들어와서 저마다의 회복을 해야하는 것이 아닐까

그렇게 다음날 출근을 할 힘을 얻지 않어야 하지 않을까

누군가는 누워서 유튜브를 볼 수도 있고

누군가는 가만히 앉아 있을 수도 있고

누군가는 다른 공부를 하며

일과 잠시 멀어지는 것.

특별한 것이 아니더라도 좋다.

하루 간 있었던 일을 잠시 뒤로하고 마음 편히 회복할 수 있다면 그것으로 족할 것이다

예술

무엇이든 아는 게 있어야 감정으로 연결시킬 수 있는 것 같다.

날씨와 음식, 노래 등 지금드는 감정 또는 앞으로 느낄 감정을

있는 그대로의 단어로 표현하는 것이 아니라

다른 언어로 표현하는 것.

그런게 예술이 아닐까 싶다.

그래. 나는 그런 삶을 살고 싶다.

지금 기분, 분위기를 다른 단어로 표현하는 사람

그래서 처음엔 그 기분을 정의하기 위해 글을 쓰기 시작했다.

어쨌든 "표현" 이라 하는건 무언가를 설계하고 만들어야 하는 것이다.

어떤 감정을 표현하기 위해 다른 곳에서 표현들을 빌려와서 재조립해야 하는 것이다.

그렇다면 나는 내 감정을 어떤 단어를 재조립해야할까?

'Think' 카테고리의 다른 글

| 위로 (0) | 2024.06.26 |

|---|---|

| 퇴근후의 공허함 (1) | 2024.06.19 |

| 관계의 이유 (1) | 2024.06.05 |

| 충분히 슬퍼할 시간 (0) | 2024.05.31 |

| 어린시절 경험에 대하여 (1) | 2024.04.22 |

관계의 이유

"사랑하는 사람이나 친구를 떼어놓고 떠나게 하는 곳은 지옥이라는 것"

사람이란 왜 관계에서 벗어나지 못할까. 주변인에 얽매이게 하고, 함께 가라,

같이 가라 말하는 걸까, 왜?

굳이 주변과 어울릴 필요가 있을까?

모든 것을 버리고 새로운 곳에서 시작할 수는 없는 존재인가?

어울린다는 것의 사전적 정의는

'함께 사귀어 잘지내거나 일정한 분위기에 끼어들어 같이 휩싸이다.'

사람은 어디에서나 잘어울리면된다. 굳이 옛사람들에 얽매이지 않아도 된다

사랑하는 사람이나 가장 가까운 친구를 떼어놓고 떠나게 해도 또 그곳에서

다양하게 어울리며 살면된다. 굳이 얽매일 필요는 없지 않을까?

사실 과거의 인연에 얽매일 필요는 없다.

그저 나를 이해해주는 사람, 나를 공감해 주는 사람들과 얽매여야 할 것이다.

그곳이 어디가 되었든 말이다.

하지만 그런 것들은 대부분 오랜기간 동안 함께 시간을 지새워온 사람들에게서 발현되니

그런 생각이 들었을 뿐이다.

그렇다면 사람은 왜 사람에게 얽매여야하는 것일까?

관계하여야 할까?

아티스토 텔레스의 시학에서는 공포와 연민을 통해 카타르시스를 느낀다고 한다.

연민을 통해 주인공이 부당하게 불행해졌을 때를 슬퍼하고

나에게 비슷한 일이 생기길 두려워할 때

감정을 배설하고발산할때 감정의 순화가 일어나게 되는 것이다.

이처럼 우리는 주변에 비슷한 처지에 놓인 사람을 보며 연민하고

공감하며 서로에게 감정의 순화를 일으켜준다.

그리고 다음날 아침을 순조롭게 맞이할 수 있게 해 준다.

이것이 우리가 주변과 관계하고 얽매여야 하는 이유가 아닐까

어차피 죽음에 패배해야 하는 삶이지만 좀 더 아름답게 패배하기 위해...

'Think' 카테고리의 다른 글

| 퇴근후의 공허함 (1) | 2024.06.19 |

|---|---|

| 예술 (0) | 2024.06.12 |

| 충분히 슬퍼할 시간 (0) | 2024.05.31 |

| 어린시절 경험에 대하여 (1) | 2024.04.22 |

| 새해 (1) | 2024.01.01 |